IA : La Plus-Value des Prompts dans Salesforce

IA : La Plus-Value des Prompts dans Salesforce

La notion de Prompt n’est plus à présenter, avec l’avènement de l’IA Générative grand public, comme Chat GPT ou Claude.

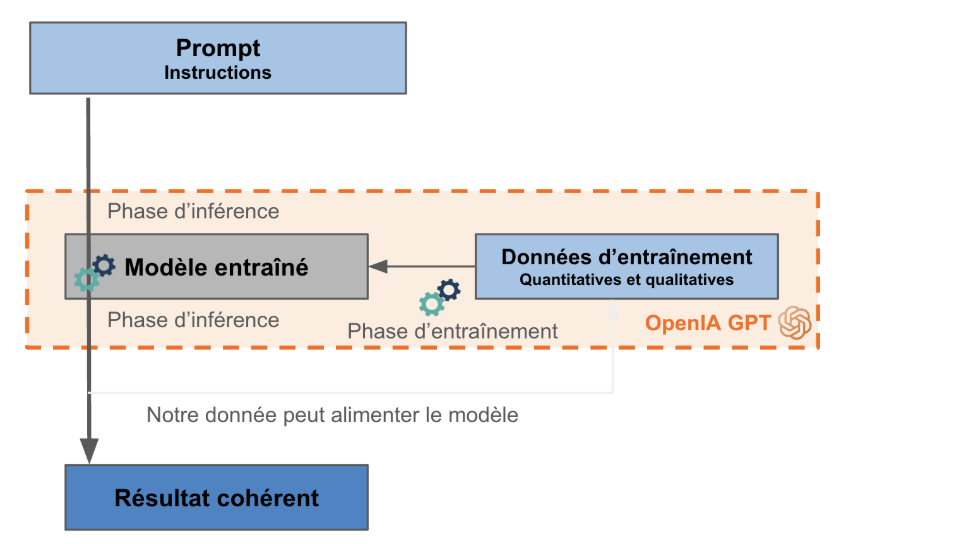

Pour mieux comprendre en quoi Salesforce propulse l’utilisation des LLM (Large Language Model), on va tout de même décomposer et décrire les composantes de l’utilisation d’un LLM :

- Nous avons une instruction (=prompt), qui doit être le plus clair possible, en contenant un contexte (rôle du rédacteur de la réponse, audience,…), l’objectif, le ton, la forme,…

- Nous avons des données d’entraînement qui doivent être le plus quantitative et qualitative possible pour obtenir un modèle robuste. (Dans le cas du LLM, il s’agit des pages web et autres articles textuels reconnus comme de confiance)

- Nous avons un modèle qui a été entraîné – lors de la phase d’entraînement – et qui est prêt pour la phase d’inférence (qui digérera l’instruction)

- Nous avons enfin la réponse qui est le résultat le plus cohérent, et statistiquement, celle qui est la plus probable.

Il y’a plusieurs constatations sur l’utilisation des grands modèles de langage :

- Notre prompt et le résultat associé peuvent être réutilisés pour alimenter de nouveaux modèles ou servir de manière opaque les entreprises de l’IA

- Le prompt peut être long à construire, n’est pas dynamique et est difficilement connectable à nos données business

Maintenant, l’utilisation d’un LLM (Large Language Model) a révolutionné la manière de travailler et le paradigme de la production.

La puissance des prompts dans Salesforce

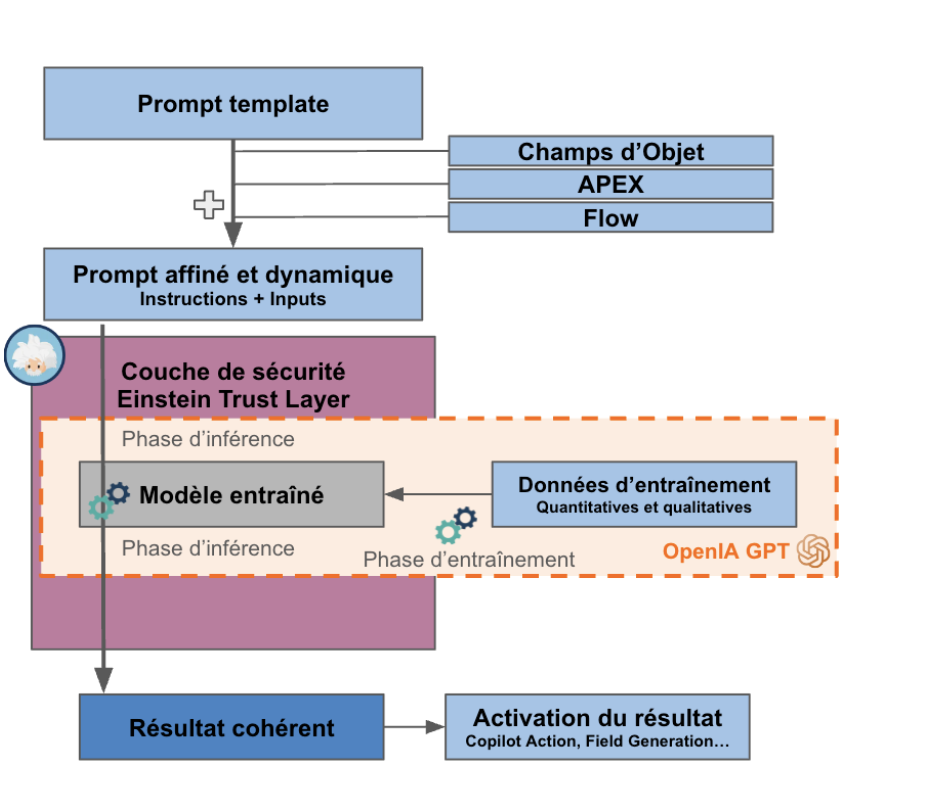

Ce qu’apporte les prompts intégrés dans Salesforce :

- Nous n’avons plus un simple prompt, mais un prompt affiné et dynamique :

- Il peut contenir des champs ou calcul issus de Salesforce : résultat d’un flow ou d’un script APEX, contenu de champs d’objets ou métadata.

- Il est personnalisé à partir d’un modèle que l’on crée : le prompt template, qui peut être “groundé” a partir d’un contexte : généré et réutilisable pour chaque Record d’un Objet donné par exemple.

- Nous avons une couche de sécurité, nommé Einstein Trust Layer qui apporte de la confiance dans l’utilisation de l’IA :

- Masquage des données confidentielles, qui seront tokenisées, c’est à dire anonymisées, au moment de l’envoi du prompt au LLM.

- Zero-retention : Les LLM ne conservent pas notre donnée d’entreprise, et ne peuvent donc pas l’utiliser pour entraîner leurs modèles.

- Protection des utilisateurs avec le score de toxicité et les règles de gouvernance.

- Activation du résultat… et c’est là toute la valeur pour le business : Que ce soit pour alimenter des valeurs de champs, pour créer un type d’action spécifique dans notre agent (Copilot) ou encore générer des drafts de mail. L’activation permet de faire évoluer vos processus et faire gagner un temps précieux de rédaction ou de recherche à vos collaborateurs.

Conclusion – L’intégration de l’IA dans Salesforce révolutionne le quotidien des entreprises en optimisant leurs processus, en boostant leur efficacité et en enrichissant leur prise de décision. Avec la suite Einstein, l’IA devient un partenaire intégré dans l’interface habituelle, d’abord en automatisant des tâches simples, puis en propulsant la transformation des processus. Cette approche ouvre la voie à de nouveaux paradigmes d’utilisation de l’IA, offrant un potentiel d’innovation et d’agilité sans précédent dans le monde professionnel.

Sources :

– Généralités : https://www.salesforceben.com/the-definitive-guide-to-einstein-gpt-salesforce-ai/

– Prompt template : https://salesforcegeek.in/prompt-templates-in-salesforce/

– Einstein trust layer : https://www.salesforce.com/artificial-intelligence/trusted-ai/